Les projets « Big Data » rendent l’information compréhensible, utilisable, partageable et ouverte. Ils constituent le meilleur outil, tant attendu, pour plus de transversalité et un réel travail collaboratif dans l’entreprise. Autre changement, le temps du « Big Data » est rapide : 5 à 8 semaines pour extraire les données, les analyser, bâtir des modèles fiables et déclencher les premières actions. Tout ceci mis en oeuvre pour et par des « task forces » transverses pour réellement permettre le mix d’expériences et de cultures, accroître la diversité et donc la richesse des analyses. Enfin un vrai levier technologique pour l’organisation matricielle qui souffrait depuis ses origines du non partage ou d’une incompréhension des informations entre des forces issues des « silos » fonctionnels, métiers ou géographiques du passé.

Par Christophe SEVERS I Directeur Conseil BI, Keyrus Belgique et Bertrand FROT I Associé de Keyrus Management

Un projet « Big Data » consiste à marier de gros volumes de données détaillées et différentes pour construire en 5 à 8 semaines des modèles d’analyse. Par exemple nous allons étudier les comportements des consommateurs d’un site en fonction des pages consultées, des produits présélectionnés, du temps d’attente entre deux actions et de l’heure de connexion… Voire relier ces comportements à des remarques postées sur des blogs. Nous allons ainsi construire des modèles pour cibler les meilleurs potentiels et agir rapidement (offres, relances, services complémentaires, appels…).

Les entreprises peuvent désormais comprendre des phénomènes complexes et surtout faire partager ces analyses pour accroître leur intelligence collective.

Des capacités d’analyse inédites qui facilitent le travail collaboratif

Si la granularité n’est pas un concept neuf (on « zoome » jusqu’à la donnée la plus fine afin de développer des analyses spécifiques : profitabilité par ligne de commande, suivi des mouvements physiques des produits, analyse du comportement d’un consommateur…), le « Big Data » apporte une capacité d’analyse croisée et détaillée, permettant de découvrir des informations jusqu’alors inconnues. Un exemple immédiat est l’utilisation des données issues des compteurs intelligents dans le domaine de la distribution d’énergie.

L’accès à une telle puissance d’analyse sur des ensembles variés de données offre une véritable valeur ajoutée : on comprend des comportements, on détecte des tendances, des « patterns », des regroupements… Si le « Data Mining » portait sur des échantillons, les technologies de « Big Data » nous offrent la capacité à découvrir des évolutions, des relations sur une population entière. Il devient possible de tester des hypothèses en temps réel et de « factualiser » les décisions. Et alors que des centaines d’attributs caractérisaient hier un client ou un profil, demain, ce sont potentiellement plusieurs milliers d’attributs dont disposeront les entreprises.

Partager un environnement complexe

Les systèmes analytiques traditionnels – symbolisés par les tableaux de bord – proposent avant tout des chiffres et des indicateurs sur des « silos », dont l’interprétation peut parfois se révéler ardue. Ces tableaux ne rendent pas compte d’univers complexes comme des usines automobiles par exemple, où il faut accéder en temps quasi réel à des données « ressources humaines » (présence des équipes), logistiques, robotiques…, utiliser des référentiels internes et ceux de fournisseurs, marier des données de flux, par actif, par personne… Une image est beaucoup parlante que plusieurs tableaux, elle permet d’agir et de communiquer. Autre exemple, quoi de plus simple que d’ajouter une photo prise avec un téléphone à un constat d’assurance ?

De telles analyses nécessitent une collaboration étroite entre le marketing, les commerciaux, les centres d’appel, les logisticiens, les contrôleurs de gestion… Impossible d’agir seul, ni même de retenir une information qui pourrait profiter à d’autres directions. Avec l’informatique comme arbitre, d’autant plus que les ressources sont rares, la transversalité se renforce autour de données objectives, et le « Big Data » matérialise ainsi l’intelligence collective d’une organisation.

Une agilité retrouvée

Les formats des données issues de nouveaux dispositifs – appareils mobiles, capteurs/puces RFID, « Open Data », applications Web, blogs, réseaux sociaux… – sont très différents, mais leur exploitation ne pose quasiment plus de problèmes, même si certaines techniques restent à affiner (comme l’extraction de contenu des vidéos).

Les perspectives de développement sont quasiment illimitées puisqu’elles dépendent désormais de la capacité de l’entreprise à imaginer de nouvelles combinaisons. Ces sources commencent à être utilisées dans les assurances, la sécurité : les réseaux sociaux servent à vérifier des déclarations. Certaines marques sont capables de comparer leurs ventes et l’apparition des noms de leurs produits sur Internet (dans des blogs, sites de contenus) ou dans des « tweets ». Avec les coordonnées de ces « tweets », ils peuvent rapidement contacter les clients potentiels. Dernier exemple, des « call centers » analysent des enregistrements de voix.

Un mode projet rapide et itératif

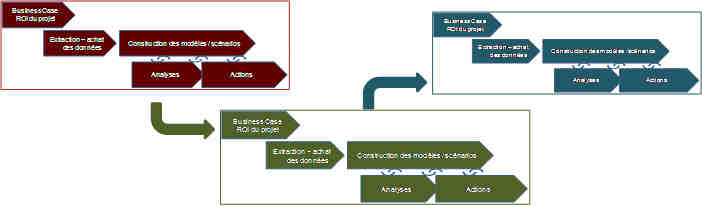

Les 5 phases types d’un projet « Big Data » sont : Etude de ROI du projet, Extraction, Construction de modèles/scénarios, Analyse et Action. Le tout en moins de 2 mois. Nous sommes loin des plannings des projets de mise en place d’ERP. Nous aurons au contraire une galaxie de projets rapides, s’enrichissant les uns les autres (un modèle sur la profitabilité commerciale pourra être repris par les logisticiens, puis les acheteurs, pour étendre l’analyse à la Supply Chain).

Le « Big Data » n’est rien sans les technologies de visualisation qui l’accompagnent – Aujourd’hui, les entreprises revoient leur portefeuille d’applications analytiques avec un goût prononcé pour le « best of breed ». Le marché logiciel actuel offre en effet une constellation de technologies innovantes qui répondent chacune a un ou plusieurs besoins précis. Des solutions existent donc pour chaque entreprise qui permettent d’exploiter de manière agile les données variées et détaillées à leur disposition.

Puisque les données sont plus manipulables, le « Big Data » devient aussi synonyme de proactivité : il devient plus facile d’établir des scénarios, des simulations. Par exemple, quel serait l’impact d’une promotion sur la ville de Marseille, pendant tel évènement culturel (avec un taux de fréquentation récupéré des sites « Open Data » de la ville) et en fonction de la météo ? Je peux simuler l’évolution des ventes, de ma marge et donc discuter plus factuellement avec les distributeurs du coût de la promotion.

En outre, les tableaux de bord traditionnels vont peu à peu muter vers des outils offrant de réelles informations plutôt que de simples données agrégées – c’est le concept de « Discovery Analytics » pour piloter les opérations et non plus seulement la performance finale. Ici aussi le « Big Data » va contribuer à transformer radicalement l’entreprise.

La révolution des usages est en marche

La capacité à combiner plus de données va renforcer la transversalité dans l’entreprise. Et plus de transversalité accroît la réactivité et accélère les cycles – réponses plus rapides aux demandes des clients, à l’évolution des besoins, aux questions des partenaires et des fournisseurs. Ceci transforme nos modes de collaboration et remet en cause la hiérarchie traditionnelle. Les fonctions transverses (Achats, RH, Marketing, Finance…) auront mis leurs données, intelligibles, au service des opérationnels ; leurs interventions dans les processus de décisions quotidiens seront différentes.

Cette transversalité renforce l’autonomie de décision et d’action des opérationnels. Par exemple, un commercial verra instantanément qu’un client n’est pas rentable et surtout pourquoi : un trop grand nombre de livraisons, un mix produit déséquilibré par rapport à d’autres clients comparables… Il sera plus autonome pour comprendre les enjeux et pourra donc agir rapidement en conséquence.

Cette transformation des processus s’accompagnera inévitablement d’une évolution des modes de construction des entrepôts de données, voire des méthodes de gestion de projets et des architectures techniques. La tendance est à la décentralisation des éléments composant la donnée, pour aboutir au final à une vision purement logique (on ne pensera plus « Data Center », mais « données », un peu à la manière du « Cloud Computing » aujourd’hui). De plus, les opérationnels vont se réapproprier les compétences informatiques si nécessaires à leurs actions. En conséquence, c’est aussi le paysage de la Direction Informatique qui devrait se transformer dans les années à venir.

Plus étonnant, la frontière de l’entreprise devient mouvante. A qui sont les données qui construisent les décisions : aux clients ? A l’espace public ? Où s’arrête la responsabilité de l’entreprise : toujours au salarié ? Les sociétés sont de plus en plus interconnectées intimement avec leurs clients, leurs fournisseurs, les réseaux personnels de leurs salariés et l’espace public. Elles se présentent de plus en plus comme une confédération mobile (fournisseurs, fabricants, clients, salariés, investisseurs, espace public…) autour d’une marque, d’un service ou d’un produit.

Des compétences rares

Si le « Big Data » provient d’une évolution technologique, il prépare donc une profonde révolution. Les premières applications montrent tout le potentiel des données disponibles enfin exploitables (les compteurs intelligents n’inventent pas les données de consommation – rien de neuf ici – mais l’usage qu’on peut en faire est fantastique : réduction de la facture, optimisation du réseau, sécurité des lieux….).

Nous allons assister à l’émergence d’un vrai marché de données, où les données des entreprises et les données personnelles se valoriseront entre elles ; ce qui pose des questions de protection et de sécurité que de rares pays comme la France ont commencé à réglementer.

Nos entreprises vont encore progresser dans la transversalité, le déclenchement de « task forces » et renforcer l’autonomie des opérationnels. Il reste encore un peu de chemin à parcourir et le marché des technologies va arriver à maturité. Quelques problèmes doivent être réglés en urgence, comme celui de la disponibilité des compétences (un problème aigu pour 46% des professionnels interrogés lors de la dernière enquête TDWI)1. Les premiers à évoluer prendront rapidement plusieurs longueurs d’avance.

1 http://tdwi.org/research/2011/09/best-practices-report-q4-big-data-analytics/asset.aspx?tc=assetpg

…………………………………………………………

Christophe Severs est en charge du pôle Conseil BI au sein de Keyrus Belgique, et des Relations Analystes pour le Groupe Keyrus. Fort d’une douzaine d’années d’expérience en décisionnel, il cultive une proximité quotidienne tant avec les clients du Groupe que les principaux acteurs et innovateurs du marché, permettant ainsi, par une innovation réfléchie et pragmatique, la mise en place d’organisations et de solutions décisionnelles rapidement créatrices de valeur.

Bertrand Frot est associé de Keyrus MANAGEMENT. Diplômé d’HEC (1988), il a une double expérience dans l’industrie et dans le conseil. Il a accompagné avec succès de nombreux programmes de transformation et mises en place de systèmes. Il est spécialiste dans le choix et positionnement des technologies et des modèles organisationnels au service de la performance et de l’efficacité des opérations.